Hallucinant... ChatGPT vecteur de cyberattaque

ven, 09/06/2023 - 14:54

L'intelligence artificiellle en général et ChatGPT en particulier sont à la mode en ce moment, c'est le moins que l'on puisse dire. Beaucoup y voient un outil génial, mais d'autres sont moins optimistes et sentent arriver les problèmes. Il est souvent mis en avant que l'intelligence articielle et ChatGPT peuvent aider les développeurs et le monde de l'informatique. Mais si ChatGPT était aussi un vecteur de cyberattaque ?

C'est ce que l'on apprend à la lecture d'un long billet écrit par l'équipe de recherche Voyager18 de Vulcan Cyber qui nous fait découvrir une attaque d'un nouveau genre : l'attaque par hallucination :-)

Le billet plante le décor ainsi : "ChatGPT peut offrir des solutions de codage, mais sa tendance à l'hallucination offre une opportunité aux attaquants. [...] Dans nos recherches, nous avons découvert que les attaquants peuvent facilement utiliser ChatGPT pour les aider à diffuser des packages malveillants dans les environnements des développeurs.“

Les chercheurs expliquent avoir vu ChatGPT générer des URL, des références et même des bibliothèques de code et des fonctions qui n'existent pas réellement. Si ChatGPT fabrique des bibliothèques de code (paquets), les attaquants pourraient utiliser ces hallucinations pour diffuser des paquets malveillants sans utiliser de techniques familières comme le typosquattage ou le masquage.

Ces techniques sont suspectes et déjà détectables. Mais si un attaquant peut créer un package pour remplacer les « faux » packages recommandés par ChatGPT, il peut être en mesure d'amener une victime à le télécharger et à l'utiliser.

L'impact de ce problème devient clair si l'on considère que, alors qu'auparavant les développeurs recherchaient des solutions de codage en ligne (par exemple, sur Stack Overflow), beaucoup se sont maintenant tournés vers ChatGPT pour obtenir des réponses, créant une opportunité majeure pour les attaquants.

Les chercheurs précisent : La technique repose sur le fait que ChatGPT, et probablement d'autres plates-formes d'IA générative, répond parfois aux questions avec des sources, des liens, des blogs et des statistiques hallucinés. Il générera même des correctifs douteux pour les CVE et, dans ce cas précis, proposera des liens vers des bibliothèques de codage qui n'existent pas réellement.

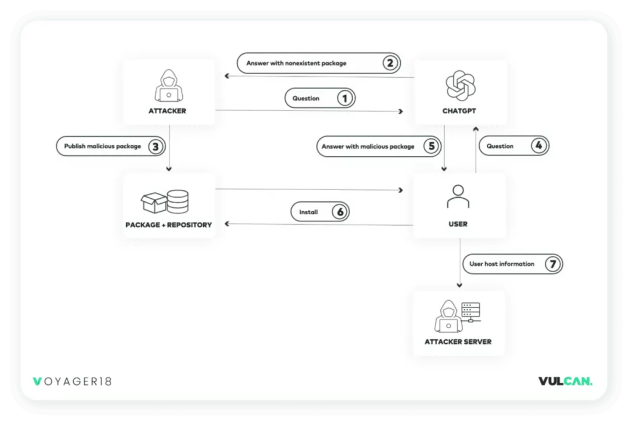

En utilisant cette technique, un attaquant commence par formuler une question demandant à ChatGPT un package qui résoudra un problème de codage. ChatGPT répond alors avec plusieurs packages, dont certains peuvent ne pas exister. C'est là que les choses deviennent dangereuses : lorsque ChatGPT recommande des packages qui ne sont pas publiés dans un référentiel de packages légitime (par exemple, npmjs, Pypi, etc.).

Lorsque l'attaquant trouve une recommandation pour un package non publié, il peut publier son propre package malveillant à sa place. La prochaine fois qu'un utilisateur pose une question similaire, il peut recevoir une recommandation de ChatGPT pour utiliser le package malveillant désormais existant. Nous avons recréé ce scénario dans la preuve de concept ci-dessous en utilisant ChatGPT 3.5.

Le billet, très intessant, détaille ensuite le modus operandi qu'un cyberattaquant pourrait suivre pour duper ses victimes.