Intelligence artificielle d'entreprise : la fondation Linux lance OPEA

jeu, 18/04/2024 - 14:05

La fondation Linux a annoncé le lancement du projet OPEA, pour Open Platform for Enterprise AI. La mission du projet est de construire et de soutenir une communauté ouverte d'intelligence artificielle (IA) et de données et de stimuler l'innovation open source dans les domaines de l'IA et des données en permettant la collaboration et la création de nouvelles opportunités pour tous les membres de la communauté. OPEA vise à faciliter et permettre le développement de systèmes GenAI flexibles et évolutifs qui exploitent la meilleure innovation open source de l’ensemble de l’écosystème.

La fondation Linux remarque les progrès rapides de la technologie GenAI ont conduit à une fragmentation des outils, des techniques et des solutions. OPEA a l'intention de résoudre ce problème en collaborant avec l'industrie pour normaliser les composants, notamment les cadres, les plans d'architecture et les solutions de référence qui mettent en valeur les performances, l'interopérabilité, la fiabilité et la préparation au niveau entreprise

Cette initiative rassemble de nombreux poids lourds du secteur, notamment Anyscale, Cloudera, Datastax, Domino Data Lab, Hugging Face, Intel, KX, MariaDB Foundation, Minio, Qdrant, Red Hat, SAS, VMware (acquis par Broadcom), Yellowbrick Data, Zilliz,…

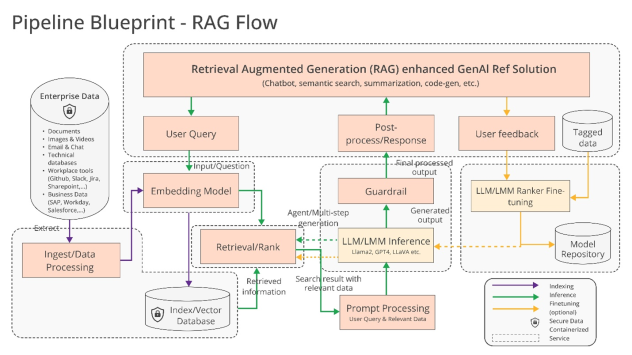

Très impliqué dans ce projet, le fondeur Intel en a publié une présentation détaillée. Intel souligne que OPEA offre une vue holistique et simple d'un flux de travail GenAI qui inclut la génération augmentée de récupération (RAG) ainsi que d'autres fonctionnalités selon les besoins. Les éléments constitutifs (ouverts et propriétaires) de ce flux de travail incluent :

- Modèles GenAI – grands modèles de langage (LLM), modèles de grande vision (LVM), modèles multimodaux, etc.

- Ingestion/traitement des données

- Intégration de modèles/services

- Magasins de données d'indexation/vecteur/graphique

- Récupération/classement

- Moteurs rapides

- Garde-corps

- Systèmes de mémoire

Implémentation de référence de flux RAG

Dans les mois à venir, la communauté open source et les entreprises partenaires ajouteront et feront évoluer ce cadre pour répondre aux besoins des développeurs, mais déjà Intel a placé un ensemble d'implémentations de référence dans le dépôt OPEA Github