mar, 11/10/2016 - 11:41

Depuis 5 ans, le Data Scientist caracole en tête des profils les plus recherchés et, pour cause de rareté, les plus difficiles à recruter. Cette situation pourrait changer à court terme : l’arrivée d’outils facilitateurs va accélérer une certaine démocratisation de la Data Science et obliger ceux qui sont perçus comme l’élite actuelle des métiers de la donnée à investir de nouveaux champs de compétences.

Il est communément admis que la Data Science est à la croisée de différentes disciplines : mathématiques appliquées, statistiques, Machine Learning, Computer Science, Business Intelligence, Data Visualisation… Devant cette énumération, on ne s’étonne pas que l’expression "couteau suisse" soit si fréquemment employée pour qualifier le Data Scientist ! C’est d’autant plus justifié qu’à ces nombreuses compétences, déjà largement pluridisciplinaires, il convient d’ajouter une solide connaissance des enjeux métiers, couplée à des talents communicationnels, indispensables pour dialoguer avec les différents métiers de l’entreprise. Tel est le profil du "vrai" Data Scientist – celui que les grandes entreprises du monde entier recherchent pour une mission à très forts enjeux stratégiques : détecter dans la donnée, quelle que soit la nature de celle-ci, de nouveaux leviers de création de valeur pour l’entreprise.

Introuvable ou irremplaçable ?

Si l’on s’en tient à cette définition élitiste du Data Scientist, il faut se rendre à l’évidence : la population éligible à la fonction est fort réduite et ne suffit pas à satisfaire la demande. Non seulement le Data Scientist est rare mais, de plus, les meilleurs se tournent vers les GAFA1 qui, outre des ponts d’or, leur offre des perspectives d’évolution souvent particulièrement séduisantes.

Pour comprendre cette pénurie, il est intéressant de se pencher sur ce qui, selon maints articles parus ces dernières années, distinguerait le Data Scientist des autres professionnels de la donnée. Il serait, dit-on, plus "pertinent" qu’un Data Analyst parce qu’il va plus profondément dans l’analyse des données et met en oeuvre des méthodes plus sophistiquées dans le but non pas de répondre à une problématique mais de découvrir de nouvelles pistes de réflexion. Il se différencie aussi du pur statisticien, du moins si on se réfère à cette citation qui a fait le tour du Web : « Data Scientist - Person who is better at statistics than any software engineer and better at software engineering than any statistician »2. Le spécialiste du Data Mining, discipline souvent considérée comme la première marche de la Data Science, est lui aussi moins ferré que le Data Scientist en Computer Science. Enfin, si le mathématicien a une meilleure connaissance théorique des modèles, il lui manque souvent cette culture de la donnée qui caractérise le Data Scientist.

Une élite purement conjoncturelle ?

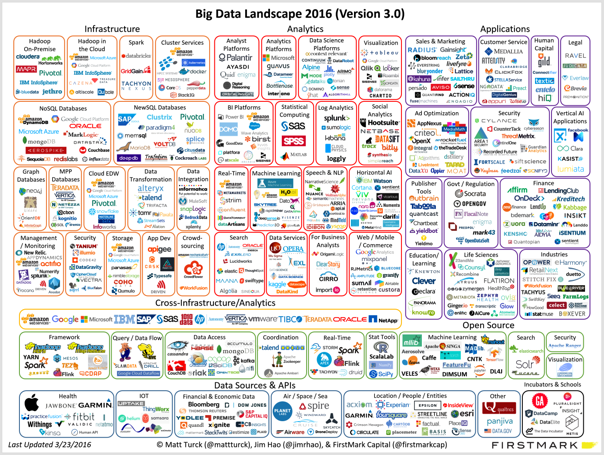

Le métier de Data Scientist est né d’un double "déluge" : d’une part, le déluge des données, couramment qualifié par ses trois "V" pour volume, vitesse et variété ; d’autre part, le déluge des solutions informatiques, très bien mis en évidence par l’évolution du Big Data Landscape entre 2014 et 2016. Dans ce paysage en évolution rapide, le Data Scientist est l’homme providentiel de l’ère du Big Data : connaissant les outils et maîtrisant les méthodes, il est plus que tout autre capable de "faire parler les données" – qu’il s’agisse d’y trouver des pistes de croissance insoupçonnées ou de révéler des phénomènes destructeurs de valeur.

Concernant le déluge de données, le volume n’est pas un réel problème : des solutions, à la fois de stockage et de traitement analytique, gèrent parfaitement cette dimension. La vitesse et surtout la variété restent en revanche de vrais enjeux. En effet, la création de valeur provient de l’analyse conjointe de trois catégories de données : les données internes, désilotées et structurées dans des Data Warehouses SQL ; les données semi-structurées telles que les logs Web, machine ou XML ; et les données dites non-structurées textuelles, images, vidéos, etc. Tout l’art du Data Scientist est de réconcilier l’ensemble de cette information en utilisant le ou les outils appropriés, quel que soit le langage ou l’environnement technologique. Des données brutes, il fait émerger de la connaissance en créant ou choisissant les features3 les plus pertinents, en appliquant la bonne méthode de Machine Learning ou, de plus en plus souvent, des blends de modèles à partir d’une sous-couche constituée d’un grand nombre de modèles préexistants.

En l’état actuel des choses, on peut affirmer que la demande en Data Scientists de haut niveau est directement liée à la complexité et à la variété des sources de données. Elle est surtout justifiée par la nécessité de maîtriser les outils et langages de programmation spécifiques à l’écosystème Big Data. Or, du fait même de l’évolution à court terme de cet écosystème, ces compétences techniques seront de moins en moins indispensables.

Émergence rapide de nouveaux outils facilitateurs

Il y a quelques années, le traitement des données semi- et non-structurées nécessitait une réelle expertise en Data Management et en développement. Les logiciels de Text Mining et, plus largement, de traitement automatique du langage n’étaient ni très pertinents, ni suffisamment performants. Actuellement, on trouve sur le marché des solutions sous licence et surtout Open Source permettant de traiter ces données non-structurées de manière beaucoup plus automatisée. Il faut certes encore de nombreuses compétences en analyse, mais une très grande partie des prétraitements est déjà intégrée et s’utilise très simplement. Pour les données semi-structurées, l’évolution est encore plus radicale. On peut désormais structurer ce type de données avec l’appel d’une seule ligne de code sous Python, par exemple. On trouve même sur le marché des solutions permettant de faire du Data Blending4, quel que soit le format des données (structurées/non structurées) ou le format de stockage (base de données SQL et NoSQL).

Tout indique que la gestion de la variété des données cessera très prochainement d’être un problème. La nécessité de maîtriser une multitude de langages de programmation pour répondre à la diversité des problématiques business va elle aussi reculer. Il n’y a pas si longtemps, il fallait vraiment être informaticien pour coder sous Hadoop ou sous Spark. Aujourd’hui, Hadoop est principalement utilisé comme une solution d'entrepôt de données. En revanche, Spark s'impose en proposant une structure et des fonctionnalités de gestion de la donnée de plus en plus simples à implémenter au fil des versions. Si la solution analytique permettant de réaliser n’importe quel type de traitement, au sein d'un environnement distribué ou non, dans un langage de programmation stable et maîtrisé par le plus grand nombre n’existe pas encore, la tendance, elle, est bien réelle.

Une démocratisation inévitable et souhaitable

La Data Science est en train de se doter d’outils qui vont la rendre plus largement accessible. On ne peut que s’en réjouir pour les entreprises qui, faute de moyens et de compétences, restaient en marge de la Data Economy. Cette démocratisation par les outils élargit le vivier de ressources humaines dans lequel elles vont pouvoir puiser et permet de faire monter en puissance des profils connexes mais moins techniques et moins polyvalents que le Data Scientist tel qu’on le définit encore. Ce sera notamment le cas du Data Miner qui pourra s’appuyer sur des modèles de Machine Learning déjà intégrés et paramétrés, sur des solutions applicatives classiques, avec des interfaces utilisables par des non experts et un langage de programmation accessible à tous. Mais que devient le Data Scientist dans ce scénario ? L’intégration d’une partie de ses compétences techniques dans les outils lui donne l’opportunité de développer deux dimensions essentielles de son activité : la capacité à communiquer sur les résultats obtenus, qui passe notamment par la maîtrise des outils de Data Visualisation, et la collaboration plus étroite avec les métiers, indispensable pour concrétiser les apports de la Data Science et ancrer la culture de la donnée au cœur même de l’activité. Pour ceux qui ont une réelle appétence pour ces deux orientations, il n’y a aucune raison pour que le métier de Data Scientist ne cesse encore quelques années d’être « le job le plus sexy du XXIe siècle » 5.

1 GAFA est l'acronyme constitué des géants du web les plus connus (Google, Apple, Facebook, Amazon)

2 On la trouve pour la première fois en mai 2012, dans un tweet du Data Scientist Josh Will. Les querelles de chapelle ne manquant pas, on croise aussi cette définition plus grinçante : « Data Scientist – Statiscian living in the Silicon Valley »

3 Premier niveau de transformation appliqué aux données brutes pour les structurer et/ou les agréger de manière à avoir une informatique plus synthétique et exploitable.

4 Notion créée par un éditeur de logiciel qui traduit le fait de réconcilier des données de natures et de formats différents en mode agile

5 Référence au célèbre article de Thomas H. Davenport et D.J. Patil « Data Scientist: The Sexiest Job of the 21st Century », Harvard Business Review, octobre 2012.

A propos de l'auteur

Nicolas Marivin

Responsable des opérations du département Big Data & Analytics, Nicolas Marivin possède une expérience de plus de 15 ans dans le domaine de la valorisation de donnée. En complément de ses activités de management des offres Business Analytics, Data Science et Big Data, il intervient sur des missions d’innovation et de modernisation de systèmes d’information.

Bouzid Ait Amir

Diplômé en Econométrie à la Toulouse School of Economics et en Informatique à Télécom Bretagne, Bouzid AÏT AMIR, possède une expertise de 15 années dans le domaine de Data Science qui lui a permis d’accompagner les plus grandes entreprises en France dans leur transformation et la mise en œuvre de solution analytique innovante.