mer, 21/05/2014 - 15:48

Devant la multiplicité des types d’attaques – de plus en plus difficilement détectables avec les attaques à signature faible -, devant les scandales qui ont émergé ces dernières semaines comme le montre la faille généralisée « Heartbleed » ou « les révélations de l’affaire Snowden », notre étude globale sur la sécurité informatique dans le monde (Global Threat Intelligence Report – GTIR, page 52) fournit quelques conseils comme :

- Mettre en place les normes ISO 27001 et PCI/DSS et impliquer tous les collaborateurs,

- Connaître en permanence tous ses actifs informatiques,

- Mettre en place un système de surveillance et d’analyse de la sécurité de son informatique réactif, en quasi-temps-réel : on favorisera l’utilisation d’une plateforme SIEM (Security Information and Event Management) basée sur un moteur de corrélations d’événements comme SPLUNK.

Mais, je pense que la refonte des réseaux mondiaux qui s’amorce sous le nouveau paradigme où le logiciel définit l’ensemble du monde IT (SDE : « Software Defined Everything » ) va faire émerger de nouvelles stratégies de défense.

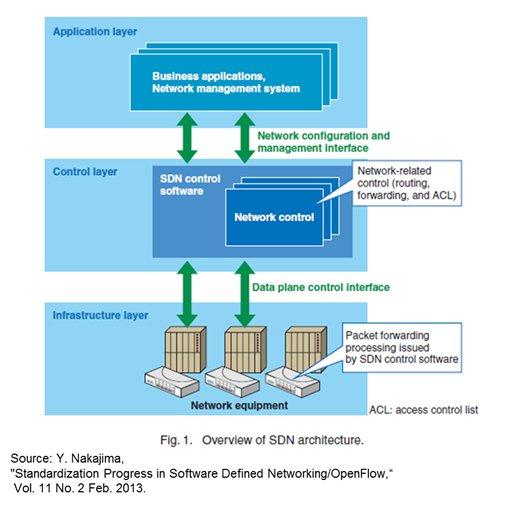

Les réseaux virtualisés vont permettre une avancée significative dans la sécurité. « Software Defined Everything » se décline dans le monde des réseaux par « Software Defined Network » ou SDN.

Des groupes de travail divers tels que I2RS (« Interface to the Routing System » : Interface avec le système de routage), IRTF (Internet Research Task Force) travaillent sur la standardisation du modèle SDN . Il existe aussi des organisations comme EWSDN (European Workshop on SDN), l’ETSI (European Telecommunications Standard Institute) ou encore NFV WG (Network Function Virtualization WorkGroup) qui se focalisent sur les services et les fonctions que peuvent porter les réseaux « logiciels » avec comme acronyme NFV (Network Function Virtualization).

Il y a donc de nombreux efforts de normalisation en cours. L’ONF (Open Networking Foundation) se concentre sur la normalisation du protocole OpenFlow, protocole qui vise à contrôler les éléments du réseau en charge du transport de données à partir d’un serveur distant.

Des efforts similaires sont réalisés par l'IETF (Internet Engineering Task Force). Ils s’efforcent de standardiser les interfaces programmables (ou API : Application Programming Interface) que l’on trouvera dans les équipements réseaux.

Or, il y a tant de travaux de recherche, qu’il est difficile de suivre tout ce qu’il se passe. Mettre en lumière les trois moteurs de cette innovation nous permettra de mieux comprendre le paysage :

- Premièrement, les opérateurs de réseaux et de services informatiques, sous la pression de la concurrence, veulent des infrastructures suffisamment souples pour pouvoir sortir rapidement de nouveaux services, de nouvelles fonctionnalités. Or, prendre un an à deux ans pour concevoir un nouveau service et le lancer commercialement est trop long.

- Deuxièmement, les clients veulent des services sur-mesure, tout en bénéficiant d’un prix moindre, en gardant une indépendance vis-à-vis du fournisseur de services choisi et en ayant la main sur la gestion des changements. En effet, au travers d’un portail, les clients seront capables de provisionner eux-mêmes de nouveaux services (circuits VPN, firewalls et leurs règles, priorisation des flux…etc..). L’objectif étant de permettre aux clients un gain de temps et donc d’argent.

- Troisièmement, si les opérateurs travaillent ensemble sur OpenFlow par exemple, c’est pour mieux créer l’émulation entre les constructeurs de matériels IT et pour s’affranchir de certaines positions monopolistiques. Grâce à ces modèles ouverts, il sera plus facile, pour un client, de migrer d'un fournisseur de services à un autre.

Aujourd’hui, ces travaux ont déjà produit de nouveaux services. Un exemple est l’automatisation des passerelles d’accès (Access Point Gateway Automation) entre les réseaux et le cloud. Ce projet consiste à automatiser les connexions des réseaux privés aux data centers. Le logiciel ici est encore le roi et l’acronyme en vigueur est le SDDC comme « Software Defined Data Center » pour aider à gérer le data center (pour en finir peut-être avec les cross-connects).

Un autre exemple est de remplacer les « appliances » - de sécurité, de gestion d’optimisation des flux..etc.. - par des services dématérialisés fonctionnant sur des clouds privés virtuels directement connectés aux réseaux privés des entreprises. Plus besoin de ces installations fastidieuses d’appliances. L’interconnexion avec des services dématérialisés dans le cloud en connexion directe avec ses infrastructures donnera aux clients un accès à de très nombreux services : c’est ce nouveau modèle que nous proposerons bientôt grâce à l’intégration des services de Virtela.

Ceci permettra au réseau d’aller à la même vitesse que le Cloud en termes de délais de livraison et d’adaptation. Cela nous donnera aussi la possibilité de développer de nouveaux services innovants et uniques sur le marché. Les réseaux peuvent désormais être paramétrés par des applications comme des ressources logiques.

Enfin, concernant la sécurité, SDN sous-entend la programmation et l’orchestration de la couche « control plane » afin de faciliter les opérations. Nous pourrons alors modifier le comportement des règles au sein même de la couche « Data Plane » et dans le cas de failles du type « heartbleed » / Open SSL, nous faciliterons le rejet des requêtes offensives ce qui empêchera en cœur de réseaux de dévoiler des informations confidentielles des clients.

A propos de l'auteur