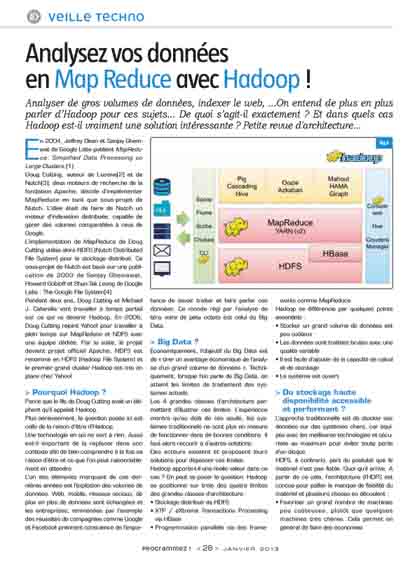

Analyser de gros volumes de données, indexer le web, ...On entend de plus en plus parler d’Hadoop pour ces sujets... De quoi s’agit-il exactement ? Et dans quels cas Hadoop est-il vraiment une solution intéressante ? Petite revue d'architecture...

En 2004, Jeffrey Dean et Sanjay Ghemwat de Google Labs publient MapReduce: Simplified Data Processing on Large Clusters,[1] Doug Cutting, auteur de Lucene[2] et de Nutch[3], deux moteurs de recherche de la fondation Apache, décide d’implémenter MapReduce en tant que sous-projet de Nutch. L’idée était de faire de Nutch un moteur d’indexation distribuée, capable de gérer des volumes comparables à ceux de Google. L’implémentation de MapReduce de Doug Cutting utilise alors NDFS (Nutch Distributed File System) pour le stockage distribué. Ce sous-projet de Nutch est basé sur une publication de 2003 de Sanjay Ghemawat, Howard Gobioff et Shun-Tak Leung de Google Labs : The Google File System[4]. Pendant deux ans, Doug Cutting et Michael J. Cafarella vont travailler à temps partiel sur ce qui va devenir Hadoop. En 2006, Doug Cutting rejoint Yahoo! pour travailler à plein temps sur MapReduce et NDFS avec une équipe dédiée. Par la suite, le projet devient projet officiel Apache, NDFS est renommé en HDFS (Hadoop File System) et le premier grand cluster Hadoop est mis en place chez Yahoo!

Rémy Saissy